本篇文章目录导航:

【题目】研究深度学习的目标检测与搜索算法??

【第一章】基于深度学习的视频运动目标绪论

【第二章】学习视频运动目标相关工作

【第三章】基于卷积神经网络的视频目标定位检测

【第四章】基于时空双流的视频人物动作检测

【第五章】基于循环神经网络的视频目标自然语言搜索

【第六章】目标检测与搜索算法的结论与参考文献

第一章 绪论

近年来,视频运动目标的检索成为计算视觉领域的重要课题之一.研究与理解视频目标检索主要包括视频结构化分析、目标检测、人物动作识别、目标的搜索.本章将首先分析此课题研究的意义与背景,接着总结国内外最新的视频目标检测与视频目标搜索方法,引申出本文的研究思路和课题创新点,最后概述论文的结构和主要研究工作.

1.1 课题研究的背景和意义

本课题部分来源于国家自然科学基金项目(61501253)、江苏省基础研究计划(自然科学基金)项目(BK20151506和BK20131382)、江苏省"六大人才高峰"第十一批高层次人才选拔培养资助项目(XXRJ-009)、江苏省重点研发计划(社会发展)项目(BE2016778),目标是通过深度学算法进行视频目标的检索.视频目标的检索最主要包含视频目标检测与是视频目标搜索两个部分.视频目标检测[1]

是指视频图片中的目标的识别与定位,对于给定的视频帧或者图片,输出视频帧或者中所有目标的位置以及目标的类别.目标搜索[2]则是指根据提供的图片或者文本,所搜出对应目标在视频图片中的位置.根据提供的图片进行目标搜索被称为基于内容的目标搜索[3],利用图片的颜色、纹理、形状等特征进行目标搜索.根据提供的文本进行视频目标的查询被称为基于文本的目标搜索[4],查询文本可能是一个单词,该单词表示了这个目标的类别,查询文本也可能是自然语言查询语句,自然语言查询语句包含了搜索目标的各方面的信息,比如位置、类别、颜色等等,自然语句搜索更加的贴近真实的应用.

随着大数据时代的到来,互联网上的视频图像资源的数据量爆炸性的增长,这种迅猛的增长方式激发了许多计算机视觉领域的相关研究人员提出有效的视频目标检索系统.这些年来,深度学习在各种视频图像领域取得了显著的突破.在图像的分类[5,6]、图像的显著性检查[7]、图像的文本描述[8]等方面都取得了不错的性能,因为深度学习的强大非线性学习能力能够表达视频图像的深层次的特征.然而在迈向视频图像更复杂的理解过程中,不仅仅需要的视频图片相关的描述与分类,更加需要的是知道视频图片中有什么物体和这些物体的位置,如何用贴近生活的语句搜索出视频图像中对应的目标.自2013年开始,深度学习开始被大量的使用在解决这类的问题,使用深度卷积神经网络识别视频图像中的目标,并且使用循环网络解决复杂文本特征的提取.

视频图像目标的检索具有巨大的应用前景和实用价值,应用到的领域包括无人汽车驾驶、智能视频监控、机械手臂抓取、机器人导航等等.并且视频图像的目标检索是更多高层次计算机视觉问题的基础比如人物的行为分析[9]、社交语义分析[10]等等.

综上所述,本文的选题具有一定的前瞻性、创新性、理论意义和应用价值.

1.2 视频目标检测概述

这一节将首先概述视频目标检测及到的基本概念,接着总结与分析国内外的最新视频目标检测方法.

1.2.1 视频目标检测基本概念

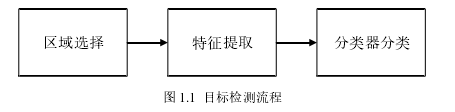

视频图像的目标检测是计算机视觉领域的一个重要的研究方向,是一种基于目标物体的几何问题以及特征提取的图像分割问题,包括识别与分割两大部分.视频图像的主要任务是找出视频中感兴趣目标的正确的位置,给出感兴趣目标的边界框,并且要准确的判断每个目标所属的类别.如图1.1所示视频图像的目标的检测方法一般分为三个步骤:

1)使用滑动窗口(Sliding Window)方法[11]或者其他的候选区域算法(Region Proposal)提取一系列的候选区域;2)提取候选区域的特征;3)使用训练完成的分类器对提取的候选区域进行分类.

1.2.2 视频目标检测方法

在传统的目标检测中,Felzenszwalb等人提出了一种多尺度形变部件模型(DeformablePart Model, DPM),DPM模型提取目标的HOG(Histogram of Orientation Gradient)特征,并且使用支持向量机(Support Vector Machine, SVM)完成分类[12].该模型充分利用了HOG特征与SVM分类器的特点,在图像处理与人脸识别等领域取得了良好的效果.但是传统的目标检测模型存在两个主要的缺点:

1)使用滑动窗口(Sliding Window)方法获取到的候选区域冗余太多,在很大程度上阻碍了后面检测的过程;2)手工设计特征HOG对于目标变形遮挡没有很好的鲁棒性.

为了解决上述的问题,近些年来卷积神经网络被用于目标检测领域.基于卷积神经网络的目标检测主要分为两大类:基于候选区域的卷积神经网络目标检测和基于回归方法的卷积神经网络目标检测.

2014年,Ross B.Girshick等人[13]首次将卷积神经网络引入到目标检测领域,提出了一种基于候选区域算法的目标检测模型R-CNN(Region-based ConvolutionalNetwork).该目标检测模型首先使用Selective search算法选出一系列候选区域,然后使用卷积神经网络提取这一系列候选区域的特征向量,最后使用支持向量机SVM完成目标候选区域的分类.实验结果证明,R-CNN在数据集PASCAL VOC 2007上的目标检测精度要比传统的DPM模型将近高两倍.之后相关领域的研究人员又提出了一些基于候选区域的目标检测方法,比如He等人提出了SPP-NET目标检测方法,该算法的核心思想是去掉了原始图像上的crop/warp等操作,引入了卷积特征上的空间金字塔池化层(Spatial Pyramid Pooling, SPP)作为替换,其主要的目的是为了解决实际处理问题的过程中输入图片大小不一的问题[14].紧接着,在2015年Girshick提出了Fast-RCNN目标检测模型,该模型的目的是为了解决R-CNN和SPP-NET方法中重复候选框的计算问题[15].同时,Ren等人又提出了Faster-RCNN目标检测模型,引入了RPN(Region Proposal Network)网络生成候选区域,进一步提高了目标的检测性能[16].虽然Faster-CNN是目前的主流目标检测算法,但是在速度上仍然达不到实时检测的要求.为此2016年,Redmon等人提出一种YOLO模型,该模型属于第二种基于回归方法的神经网络模型,每次可以进行多个类别目标的类别以及位置预测,并且实现端对端的的目标检测[17].

以上是现如今的目标检测方法,目标检测的准确率与效率逐步提升,但是仍然存在目标区域定位不够准确的缺陷.基于上述考虑,本学位论文在目标检测流程中加入目标定位修正方法,提出一种基于深度学习的目标定位检测模型.

1.3 视频目标搜索概述

这一节将首先概述视频目标搜索所涉及到的基本概念,接着总结与分析国内外的最新的视频目标搜索方法.

1.3.1 视频目标搜索基本概念

视频图像的目标搜索是计算视觉领域的另一个重要的研究方向,其目标是对于给定的查询样本图片或者查询文本,能够返回视频图像中与查询图片相似或者与查询文本描述相近地方目标.视频图像的目标搜索本质上是一种高级的图片检索,能够检索出视频图像中的局部内容,要求能够对图片感兴趣区域进行分割与识别,需要与目标检测方法相结合.

1.3.2 视频目标搜索方法

目标图像的搜索技术大致可分为两类:基于文本的图像搜索[18](Text Based ImageRetrieval, TBIR)、基于图像内容的图像搜索[19](Content Based Image Retrieval, CBIR)和基于语义的图像搜索[20] .在深度学习技术没有兴起之前,最早期的图像搜索方法是基于文本的图像搜索,通过关键词以及文本描述建立文本与图像的联系.然而因为图像的文本描述过于主观,并且随着数据量的增加,人工标记图像文本的工作量变得越来越繁重与效率低下,因此TBIR方法逐步的被弃用;在20世纪90年代,Kato等开创性的提出的了基于内容的图像搜索方法,该方法提取样例图像的底层的视觉特征如形状、纹理、颜色等等,并将其作为图像搜索输入条件,使用相似度度量方法计算输入图像特征与搜索图片特征的相似度,根据样例图片与搜索图片之间的相似度,返回最终的搜索结果[21].与TBIR相比CBIR避免了大量的人工标注操作,在一定程度上提高了图像搜索准确率.但是在CBIR方法中,只是片面的提取了整幅图像的低层次特征,忽略了图像中的局部特征,阻碍了基于语义的图像搜索的发展;基于语义的图像搜索是一种基于目标的和高级语义的搜索方法,更加贴近图像搜索的实际应用需求,但低层次特征和高级语义之间存在"语义鸿沟",方法实现较为复杂.

国内外相关学者对于基于内容的图像搜索技术CBIR取得了大量的进展.该方法主要从颜色、纹理和形状这三种特征入手.颜色特征是最基本最容易实现的特征,2005年,DingGuiguang等人提出了一种基于兴趣点环形颜色直方图的目标搜索方法,该方法解决了传统颜色直方图不包含空间位置信息的缺点[22].

2008年,Lin等人提出了基于颜色共生矩阵和K均值颜色直方图的方法[23];纹理特征是比图像特征更为细致的图像特征,2003年Huang等人提出了一种基于纹理的图像搜索方法,该方法首先利用小波系数和梯度向量,对样例图片以及被搜索的图片提取出粗略的纹理特征描述子和精细的纹理特征描述子,先通过粗糙的纹理特征描述子去除部分不合格的图像,然后利用进行的纹理特征描述子计算样例图片与被搜索图片的相似度[24].

2010年,Choy等人提出通过在传统的小波变换的高频子带上建立的广义伽玛密度模型上提取图像的纹理特征进行搜索[25].形状特征则是比纹理特征更加直观的一种特征,在2016年P.Sumathy等人提出了Fuzzy-Object-Shape来获取图像中目标的形状特征,并且得到了比较良好的搜索结果[26].

近些年来,随着深度学习技术的发展,原本难以实现的基于语义的图像搜索得到了发展.

在2015年,Donahue等人提出了长周期卷积神经网络模型LRCN(Long-Term RecurrentConvolutional Networks)来完成图像的自然语言搜索任务以及图像的自然语言描述生成任务.

LRCN模型包含两层长短期记忆网络(Long Short-Term Memory, LSTM)网络,并且将嵌入词组与图片的特征作为输入[27].该方法初步实现了基于语义的图像搜索,但是图像中目标的特征与空间的信息没有得到充分的利用.为了充分利用这些信息对视频图像中的目标进行搜索,本位在LRCN模型的基础上提出视频图像自然语言目标搜索模型.

1.4 课题研究思路和创新点

本文的主要研究目标是针对视频图像深度学习领域,在检测视频图像中目标的基础上,对视频图像的目标自然语言搜索进行研究,并借鉴已有的视频目标检索模型,构建一种基于视频深度学习的视频目标的检测与自然语言搜索模型,以便准确的识别与定位目标在视频图像中的位置以及检索出与查询文本对应的视频图像目标.

本文的工作创新主要体现在以下三个方面:

(1)利用一种基于目标候选框边界概率的卷积神经网络模型,计算出目标候选边界框的四条边在一定搜索区域上的概率,获得更加接近人工标注边框的候选.通过迭代的方式与目标识别模型进行融合.

(2)将预先训练好的空间流与时间流动作检测网络在深度卷积层进行融合,利用融合后的时空双流动作检测模型提取中层时空特征提取,之后利用3D卷积神经网络模型完成视频人物动作检测.

(3)利用卷积神经网络并行的抽取局部目标区域和全局的特征,通过两层的门循环神经网络融合这两方面的特征以及自然语言搜索语句的特征来完成自然语言目标搜索.

1.5 论文主要研究工作及结构

本文对视频图形目标的检测与搜索展开深度学习、研究与实验工作.对于视频图像中的检测研究,提出了一种候选区域概率的卷积神经网络定位模型,该定位模型实现了检测过程中的候选区域位置的修正,在检测流水线中与识别模型通过迭代的方式进行融合.对于该模型,首先将候选区域扩大得到搜索区域,将搜索区域输入到定位模型中,最终在定位模型两个分支输出对应维度的边界概率,完成候选区域的位置修正.该目标检测流水线最终在PASCAL VOC数据集上进行实验.对于视频图像目标搜索研究,本文一种基于循环卷积神经网络的自然语言搜索模型,来完成视频图像中目标搜索的任务.该模型首先通过卷积神经网络提取视频中目标的特征以及目标的全局环境特征,再通过词嵌入层将自然语言搜索语句映射向量特征表示,之后使用两层的循环卷积神经网络融合提取的特征完成目标的搜索,最后在Refer It数据集上对自然语言搜索模型进行实验.

本学位论文一共分为六个章节,内容具体分为安排如下:

第一章:绪论.本章主要概述视频目标检测和目标搜索基本概念、总结国内外研究的方法与阐述本文研究的创新点和文章结构.

第二章:相关工作.本章主要概述本课题所涉及算法的结构、原理及其相关领域应用.

第三章:基于卷积神经网络的视频目标定位检测.本章主要阐述如何通过基于边界概率的定位模型,完成视频中目标的定位与识别.

第四章:基于时空双流模型的视频人物动作检测.本章主要阐述如何通过基于时空双流特征的卷积神经网络模型完成视频人物的动作检测.

第五章:基于循环神经网络的视频目标自然语言搜索.本章主要阐述如何基于GRU的模型完成视频目标的自然语言搜索.

第六章:总结与展望.本章首先总结论文的主要研究工作,包括提出一种基于卷积神经网络的视频目标定位检测算法、一种基于时空双流模型的人物动作检测算法与一种基于自然语言的视频目标搜索算法,然后讨论以上三种算法的不足之处与下一步要开展的工作.

本学位论文的文章结构如图1.2所示