本篇文章目录导航:

【题目】研究深度学习的目标检测与搜索算法??

【第一章】基于深度学习的视频运动目标绪论

【第二章】学习视频运动目标相关工作

【第三章】基于卷积神经网络的视频目标定位检测

【第四章】基于时空双流的视频人物动作检测

【第五章】基于循环神经网络的视频目标自然语言搜索

【第六章】目标检测与搜索算法的结论与参考文献

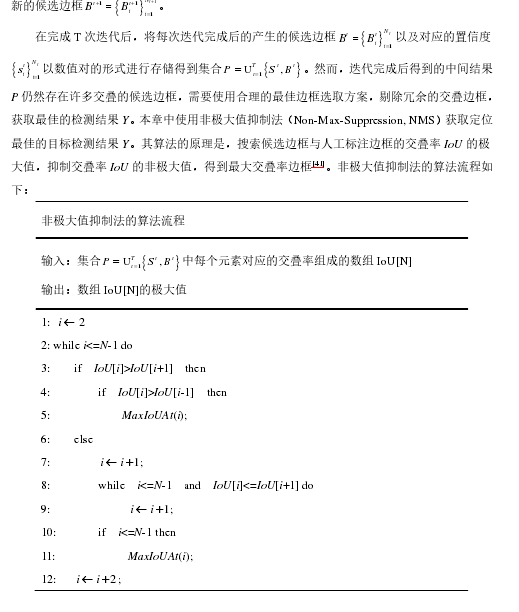

第三章 基于卷积神经网络的视频目标定位检测

在第二章中,神经网络被广泛的应用于目标检测领域,无论使用何种方法,都需要进行初始候选边框的提取。随着方法被不断改进,原有提取候选边框方法冗余的问题被解决,目标检测的准确率与速度获得了极大的提升。但是,检测位置的准确性问题一直被忽略。候选边框只能粗略的表示目标的大概位置,就算是通过回归算法微调边框位置也不能获得足够准确的位置。针对以上的问题,本章提出了一种基于卷积神经网络视频目标定位检测算法。

3.1 问题描述

现如今目标物体检测识别这一课题已经成为当下计算机视觉领域的研究热点。要求对于给定的图片或者视频帧,能够识别出图片或者视频帧中每个目标的物体的类别以及目标物体在图片中位置,在大多数目标物体检测方法中使用矩形边框作为目标物体的边框。目前有几种常见的检测算法,一种是使用滑动窗口策略(Sliding Windows)作为输入候选框生成方法的传统目标检测方法,时间复杂度太高,冗余窗口太多,严重影响了后续的分类性能。之后为了解决这个问题,另一种基于候选区域算法(Region Proposal)的深度学习检测方法被提出[38],在减少候选窗口的前提下,仍然能够保持较高的召回率。之后为了在速度上取得进展,提出了类似于YOLO的方法,该方法使用了回归思想,对于给定图片或者视频帧,直接在图像或者视频帧的多个位置上回归出这个位置的目标边框以及目标类别。

随着目标检测技术的发展,检测的精确性与性能逐步的在提升,然而这些方法对目标定位的准确性一直没有得到改善。最近提高目标检测的边框定位精确性的要求也被逐步提出,边框定位精确性由检测到的边框(Bounding Box)与人工标注边框(Ground Truth Box)的交叠率Io U(Intersection over Union)来衡量,对于交叠率Io U小于0.5的检测边框被视为检测失败。边界框回归算法(Bounding Box Regression Paradigm)被提出作为目标检测流水线的一部分,用来微调检测失败的边框,提高定位的准确性。但是,通过回归方式还是很难精准定位目标的边界框[39].

为此,本章在已有的目标检测流水线的基础上,提出一种基于卷积神经网络的目标边框概率模型定位算法,来代替目标检测流水线中的边界框回归算法,最终训练神经网络完成目标的高定位精准度检测。

3.2 基于边界框概率的卷积神经网络定位模型

第二章中以及描述了卷积神经网络的结构原理以及用途,在本章中将使用卷积神经网完成目标的定位与检测。其中,定位模型是整个目标检测流程中的重点。本章节中,将从边界概率预测的原理,边界概率表示方法以及基于卷积神经网络的模型结构三个个方面具体阐述定位模型。

3.2.1 边界框概率预测原理

本章考虑通过构造一个卷积神经网络学习任务,这个任务通过回归函数直接得到检测目标边框的位置坐标,但是实验证明构造这样的学习任务比较困难,且无法产生精确的边框,因而提出某一行或者某一列上的概率模型,通过行或者列上的概率确定边界框的位置。

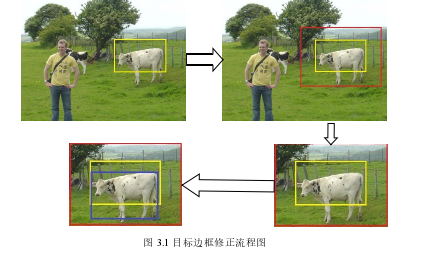

边界概率预测模型的大致工作流程如下:对于给定的图片以及图片的候选框B,以固定的倍数扩大候选框B,得到搜索区域R,设这个固定的参数为t=2,接着根据搜索区域R内的各行各列的是边框的概率或者在边框内的概率,得到一个比候选框B定位更加准确的边框。

图3.1大致表示了这样的工作流程,其中黄色的框表示原有的候选边框B,红色的边框表示搜索区域R,蓝色的边框表示新得到的候选边框。

3.2.2 边界框概率表示法

下面将详细叙述边界概率的表示方法。对于给定的搜索区域 R 和目标检测的种类 C,将

通过最大化 ( )2Loc B ,可确定第二种概率表示方法下新边界框的坐标值。

3.2.3 基于深度卷积神经网的定位模型框架设计

本章提出的基于深度卷积神经网络的定位模型Loc CNN框架图如3.2所示,该模型设计先通过深度卷积神经网络提取图片底层特征;然后,池化获取搜索区域的特征图,通过卷积层卷积得到位置感知特征图;最后,池化得到行与列的特征编码。在接下来的几段中将具体阐述定位模型框架。

3.3 视频目标的定位检测算法流程设计

在本章中提出的视频目标定位检测算法框架包含两个基本的部分,分别是目标的识别模型以及目标的定位模型。在本节提出的算法流程中,使用迭代的方法将识别模型和定位模型这两部分进行融合。

3.4 实验与结果分析

3.4.1 实验设计

本章实验所使用的数据集是PASCAL VOC数据集,该数据集为图像目标检测提供了一套标准化优秀数据,数据集的训练集中由一系列的图片构成,每一张图片都被标注了目标的边界框以及目标的类别。本章中识别模型与定位模型都将使用VOC2007和VOC2012中的训练数据作为本次实验的训练集,将数据集VOC2012中的训练数据作为本次实验的测试集。

本章的实验一次迭代过程主要分为两大步,第一步分识别模型完成视频帧中的目标检测,本章实验使用的Girshick提出的Fast-RCNN模型完成视频帧目标的识别,输入视频帧以及视频帧中目的候选边框,初始的候选边框采用Selective Search和Edge Box这两种候选边框算法方法进行提取,输出视频帧目标的候选边框以及视频目标对应类别的置信度;第二步,把上一步得出的检测目标候选边框,输入到定位模型,输出新的候选边框,得到更佳的目标检测位置。定位模型则是本章核心所在,下面将详细阐述定位模型的实验细节。

首先,对识别模型得到的目标检测候选边框进行预处理,将与人工标注边框交叠率Io U值小于0.4的候选边框剔除,对于定位过差的候选框被删除,留下候选框再以大小为2的固定参数t=2进行扩大,得到搜索区域R.定位模型输入上述预处理得到的结果,最终得到某一行或者某一列的边界概率。通过获得的概率,最终可以确定定位更加准确的候选边框。在定位过程与检测目标的种类无关,检测目标的种类不会对最终的定位结果产生影响。参数M的值控制了分支X与Y最终输出特征图的概率,被设置为M=14.为了优化训练过程中的收敛的平稳性与速率,将使用的随机梯度下降法SGD(Stochastic Gradient Descent)的有关参数进行调整[42],设置mini-batch的大小为128,每个批次的128个候选框仅仅取自于两个不同图片。权重衰减参数设置为0.00005,学习率设置为0.001,并且每60次迭代将缩小为原来的1 10.整个训练过程将一共持续150k次迭代。

3.4.2 结果分析

本章实验将从评价标准和结果对比两方面来进行结果分析。

(1)评价标准本节通过召回率、平均召回率AR与精确率指标m AP(mean Average Precision)三个量化指标分析得到的实验结果。召回率是指检索出相关目标候选边界框与所有候选边界框的比率,在本节中用来衡量边界框定位的优劣。平均召回率AR则是指召回率recall与交叠率Io U曲线与坐标轴的面积,取值范围是[ ]0,1 .平均精确率AP(Average Precision)表示准确率precision与召回率recall曲线与坐标轴的面积,取值范围是[ ]0,1 .精准度指标m AP(meanAverage Precision)则是指多个类别对应平均精确率AP(Average Precision)的均值,取值范围是[ ]0,1 .

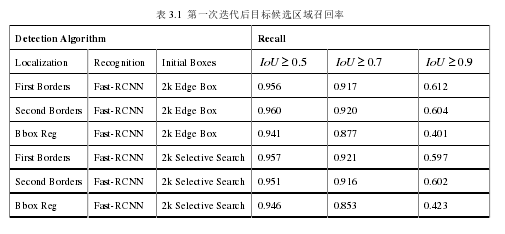

(2)结果对比首先进行本章提出的目标检测流水线中定位模型的与传统的边框回归定位模型的对比,将忽略目标识别模型方面的性能评估,并且使用召回率作为衡量定位优劣的评判标准。为此将使用同样的识别模型Fast-RCNN以及同样一些列候选边框作为定位模型的输入,在这时输出候选框的召回率的大小,反映了定位模型的定位性能。在表3.1中展示了目标检测流水线在不同定位模型下第一次迭代后,输出的候选边框的召回率随着交叠率阈值Io U发生变化的曲线。可得出结论,对于Io U阈值大于0.7以后候选边框的,本章提出的定位模型得出的召回率要大于边界框回归模型得出的召回率,并且随着Io U阈值的增大这种改进更加明显。对于平均召回率AR(average recall),本章提出的模型得出的值要比边界框回归模型得出的值平均高出6个百分点。

接着将对整个改进的目标检测流水线的目标识别性能做分析。图表3.2中的结果是整个目标检测流程经过T=4次迭代后得到的实验结果。图表给出了在测试集VOC2007上,分别给出Io U阈值在大于0.5与大于0.7时的目标检测多类别平均准确率m AP(mean AveragePrecision)。通过观察表格得出,对与交叠率Io U值大于0.7的候选边框,本章提出的第一种边框概率定位模型与第二种边框概率定位模型都能够在一定的程度上提高整个目标检测流水线识别准确率,优于边界框回归定位模型。对于交叠率Io U值大于0.5的候选边框只是提供了少许的优化。还可以得出的结论是,本章提出的改进的目标检测流水线对边界框提取方法不敏感。

3.5 本章小结

本章对于基于深度学习的目标检测技术进行了深入的研究与探索,提出了一种基于深度卷积神经网络的高精确性定位目标检测流水线。该流水线主要通过迭代的方式将识别模型与定位模型相结合,在迭代的过程中,在提高定位准确性的同时提高了目标识别的精确性。在目标检测流水线中,最重要的部分是定位模型,在接下来本章又详细叙述的定位模型的工作原理。该定位模型主要分为三个部分,第一个部分通过深度卷积神经网络VGG初步提取图片特征,第二个部分通过两层卷积神经网络提取上一步特征图中搜索区域R的特征得到一个新的搜索区域R的特征图片,第三部分,模型分裂成两个分支通过这两个,这两个分支分别得出两个维度方向上的边界框概率向量。最后,通过概率向量可以得到一个定位更加精准的边框。最后在实验部分,通过召回率与准确率作为评价的标准,对目标检测水线进行验证。

实验结果证明,本章提出的使用定位模型目标检测要比使用边界框回归模型目标检测,候选框召回率与识别准确率要高。说明,本章提出的定位模型能够更加定位准确的识别出视频帧中的目标。

但是该模型仍然存在很多缺点,有待改进与提高。比如,当视频帧中存在多目标物体[43]、识别目标过小[44]以及视频帧由于天气[45]的比较模糊,这些问题没有充分考虑到。如果能够顺利的解决这些问题,目标检测能力将会获得客观的提升,后面本人将会继续研究视频中目标的动作识别。